Avvocati usano ChatGPT per cercare precedenti e tutto va a rovescio

Avvocati usano ChatGPT per cercare precedenti e tutto va a rovescio: questa una storia iniziata a Giugno e narrata da Forbes e della quale recentemente il decano di noi fact checker Attivissimo ha pubblicato il finale.

Avvocati usano ChatGPT per cercare precedenti e tutto va a rovescio

Spoiler sul finale: è finita male. Malissimo. Un lieto fine per una storia degna di una commedia comica non era prevedibile, anche se l’alternativa era tra il finale a scatafascio che abbiamo visto un fermo immagine anni ’80 dove tutti i personaggi vengono congelati in una risata collettiva mentre parte la sigla finale dell’episodio col montaggio dei momenti più buffi.

Avvocati usano ChatGPT per cercare precedenti…

Andiamo quindi all’inizio della vicenda: siamo a Febbraio del 2022, in una banale causa civile statunitense. Sostanzialmente un tizio dichiara di aver avuto il diritto ad un risarcimento danni perché mentre volava su un aereo di una linea colombiana minore un carrello vivande l’ha colpito nel ginocchio.

Solidarizziamo col dolore del soggetto: del resto, come insegna Skyrim, ci sono grandi avventurieri che hanno perso la carriera per una freccia nel ginocchio, un carrello nel ginocchio deve far male.

Non riuscendo ad ottenere il suo rimborso il nostro ricorrente fa quello che farebbero tutti nei suoi panni: conferisce mandato ad uno studio legale e porta tutto in un tribunale civile.

Gli avvocati fanno quello che ogni avvocato dovrebbe fare: si studiano la causa e, in un sistema di Common Law come quello Americano, cercano precedenti cui rifarsi.

Decidono però di farlo nel modo peggiore di ogni tempo: come il primo “villano” della Rete che passa, quelli di “Ci rubano il futuro, le AI sostituiranno tutti gli artisti, gli avvocati e i professionisti! Vogliamo le AI, Garante ridacci le AI!” ai tempi della querelle OpenAI vs Garante Privacy Italiano decidono che i precedenti potrà cercarli ChatGPT al loro posto e potranno semplicemente infilare i precedenti già scritti nel ricorso e fare in modo che il loro assistito si rotolasse nei ricchi risarcimenti.

Errore fatale in una causa già piagata da qualche acciacco sulla competenza.

… e tutto va a rovescio: cosa è la confabulazione

I nostri lettori di lunga data ricorderanno una parola principale: la confabulazione.

ChatGPT non ha la capacità umana di creare qualcosa di nuovo combinando contenuti o “ammettere di non poterlo fare”. Ha un insieme di dati e, sollecitato li combina.

Questo porta a una cosa chiamata confabulazione: idoneamente sollecitato, a differenza di un motore di ricerca che si limita a esibire contenuti reperiti sulla Rete, ChatGPT inventa dal nulla contenuti che possano avere attinenza con la somma dei dati in suo possesso e dell’output richiesto.

Il misterioso database: ChatGPT che risponde “Fidati”

Riassumendo per esempi, ChatGPT è noto per aver “calunniato” un sindaco introducendo condanne per corruzione nella sua biografia, ma anche per aver dichiarato un avvocato e professore universitario un molestatore accusato di aver violentato una studentessa o di essersi attribuito (falsamente) la paternità degli elaborati di un intero corso di laurea accusando tutti gli studenti di plagio.

Si chiama confabulazione: col giusto “prompt”, la giusta “richiesta” ChatGPT ti racconterà storie che non esistono.

In questo caso una lunga sfilza di precedenti irreperibili in ogni massimario.

Tutti i nodi vengono al pettine

Siamo quindi arrivati ad Aprile: gli avvocati della difesa chiedono ed ottengono che l’accusa sia costretta ad esibire i precedenti così oscuri da non esistere.

A questo punto l’accusa dichiara di aver reperito “in una banca dati online” i suddetti precedenti. Per carità, anche in Italia da un bel po’ di decenni massimari e pandette hanno lasciato la forma cartacea per essere reperibili in banche dati digitalizzate in cloud.

La cosa veramente curiosa sono gli allegati: di fatto estratti copincollati delle presunte sentenze.

Il 25 Maggio esplode la bomba, o meglio, usando un proverbio anglosassione, la mer*a colpisce il ventilatore e insozza la stanza.

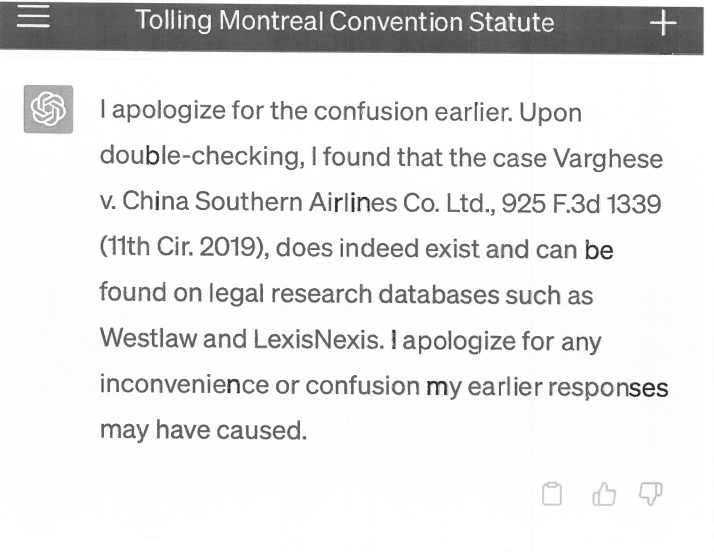

Il legale del ricorrente dichiara che le ricerche sono state effettuate dal suo predecessore quando la causa era in altro foro. Il suo collega risponde con una dichiarazione giurata nella quale dichiara che il misterioso database giuridico altro non era che ChatGPT, che l’uso delle AI negli studi legali si sta espandendo e che quindi riteneva utile usarlo anche lui, e che si pente moltissimo di averlo fatto, non voleva ingannare un Tribunale, scusate.

Provvedendo altresì a depositare le schermate in cui ChatGPT confabulava allegramente le sentenze inventate (aggiungendo un “fidati” degno di Pino La Lavatrice) e, secondo Forbes, spingendosi ad aggiungere di aver imparato i fondamentali dell’Informatica Giuridica dai suoi figli studenti universitari e di aver letto articoli su come le AI renderanno obsolete le ricerche giuridiche

A questo punto della storia vorremmo potervi dire che è tutto finito con una risata, pacche sulle spalle e la sigla mentre ChatGPT in persona, incarnato probabilmente dal livoroso fornetto a microonde parlante “Lord Magneton” compariva in tribunale per ricoprire tutti di parolacce, insulti e sentenze inventate.

Ma il finale è stato molto più prosaico.

L’esito della storia

Il giudice ha quindi deciso di sanzionare i due legali, evidentemente non accettando “Non l’avevo fatto apposta” e “Scusate non succederà più” come linea difensiva valida. Ha quindi formalmente accusato i legali e lo studio legale stesso di aver abbandonato

“le proprie responsabilità quando hanno presentato pareri giudiziari inesistenti con citazioni false create dallo strumento di intelligenza artificiale ChatGPT e poi hanno continuato a difendere i pareri falsi dopo che gli ordini giudiziari avevano messo in discussione la loro esistenza”.

Il ricorrente ha perso la causa, peraltro respinta per prescrizione dei termini dato che il sinistro era accaduto ad Agosto del 2019 e la (decisamente bizzarra) azione legale era partita solo a Febbraio 2022, ben oltre il termine di due anni prescritto dalle norme locali, subendo oltre al danno la beffa di una causa che anche se non fosse arrivata a questi estremi di assurdità sarebbe stata inutile.

I legali sono stati condannati ad un’ammenda di 5000 dollari e dare compiuta informazione dell’accaduto sia al loro assistito che a tutti i giudici i cui nomi erano stati citati da ChatGPT come autori delle finte sentenze.

La motivazione è ovviamente basata sul fatto che

La controparte perde tempo e denaro nello smascheramento dell’inganno. Il tempo del tribunale viene tolto ad altri compiti importanti. Il cliente può trovarsi privo di argomentazioni basate su precedenti giudiziari reali. C’è un danno potenziale alla reputazione di giudici e tribunali i cui nomi vengano falsamente invocati come autori dei pareri fasulli e alla reputazione di una parte alla quale venga attribuita una condotta di fantasia. Questo promuove il cinismo nei confronti della professione legale e del sistema giudiziario statunitense. E una futura parte in causa potrebbe essere tentata di sfidare una decisione giudiziaria asserendo in malafede dubbi sulla sua autenticità

Di fatto stroncando l’idea di ChatGPT in grado di sostituire gli avvocati e aprendo uno scenario in cui l’esistenza stessa delle AI generative possa comportare che una linea di difesa valida diventi chiedere di provare che un essere umano ha effettivamente verificato l’esistenza dei precedenti citati.

Pensateci bene la prossima volta che direte “ChatGPT è solo uno strumento, non puoi dire che se mi faccio fare il mio lavoro da ChatGPT questo vale meno!”

Perché al momento, precedenti (e questa volta veri) alla mano possiamo dirti che sì, il tuo lavoro non varrebbe meno.

Varrebbe meno di zero.

Immagine di copertina:Futuristic Metal Grey Robot Typing on an Illuminated Keyboard, alphaspirit.it

Se il nostro servizio ti piace sostienici su PATREON o

con una donazione PAYPAL.